La IA avanza; sus riesgos, también: anatomía de una tecnología con dos caras

El aluvión de posibilidades que ofrece se ve empañado por el uso perverso y malintencionado y la ausencia de regulaciones que la limiten

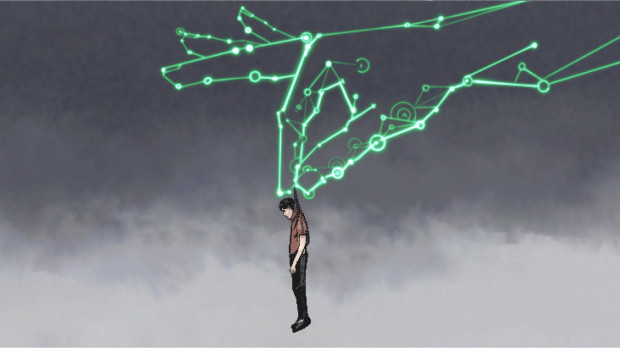

«¡Oh, no! ¡He creado un monstruo!». Las palabras del doctor Víctor Frankenstein al observar por primera vez su horripilante criatura llevan semanas resonando entre algunos de los principales tecnólogos y empresarios del mundo, incluidos los propios creadores del «monstruo».

Hablamos, como no podía ser de otra forma, de la IA, uno de los asuntos más comentados y debatidos de este 2023 desde que el pasado mes de noviembre una herramienta llamada ChatGPT (tal vez les suene) dejara boquiabierto al mundo por su capacidad para escribir casi cualquier cosa con un alto grado de originalidad, precisión y acierto al instante.

El chatbot, obra de la compañía californiana OpenAI –creada, entre otros, por Elon Musk–, no fue la primera del aluvión de herramientas con esta tecnología que hay ya disponibles para un amplio abanico de usos. Las de generación de imágenes –como Midjourney o Dall-E, por poner un ejemplo– llevaban ya algunos meses llamando la atención al ingeniar ilustraciones o fotomontajes impresionantes a partir de una simple orden.

Pero ha sido ChatGPT, sin embargo, la que ha situado la IA en un primer plano por su accesibilidad e impacto. Desde principios de diciembre, cada vez con mayor virulencia, corren ríos de tinta sobre las ventajas e inconvenientes de una tecnología que avanza a velocidad de vértigo, y en la que esta herramienta ocupa solamente una pequeña parte.

Porque conforme su desarrollo ha ido ganando músculo y alumbrando nuevas aplicaciones que pueden ser de ayuda para determinados sectores –burocracia, administración, seguridad, medicina...–, los temores a lo que el ser humano puede hacer con ella para fines inmorales o espurios han evidenciado la necesidad de no dejar que campe a sus anchas sin control. El «monstruo» del que avisan los tecnólogos no es la IA per se, sino una libre e inmoderada.

Lo avisó, de un modo cuasi visionario, el físico Stephen Hawking en 2014, cuando esta ‘maquinaria’ estaba todavía en fase embrionaria, y lo han reiterado diversas personalidades y figuras públicas en las últimas semanas. «El desarrollo de una completa inteligencia artificial podría traducirse en el fin de la raza humana. Los humanos, que son seres limitados por su lenta evolución biológica, no podrán competir con las máquinas, y serán superados», alertó entonces el divulgador británico.

Nueve años después, con un salto cualitativo apoteósico en términos de IA, la historia se ha repetido. Sam Altman, director ejecutivo de OpenAI, confesó a mediados de marzo su temor a que modelos como ChatGPT sean empleados para difundir «desinformación a gran escala». Bill Gates, con unos días de diferencia, se preguntó si «podría una máquina decidir que los humanos son una amenaza» y «concluir que sus intereses son diferentes a los nuestros». Y Elon Musk, el cofundador de Apple Steve Wozniak y otros 1.800 líderes empresariales más pidieron una semana más tarde en una carta abierta una moratoria de seis meses en el desarrollo de IA.

No estamos todavía en ese punto postapocalíptico que menciona Gates, pero lo cierto es que tampoco parece que vaya a llegar por ahora moratoria alguna. Y mientras, los innumerables trámites de los órganos legislativos ralentizan la llegada de una normativa que marque límites y ponga coto al caos.

Se ha visto y se sigue viendo –cada vez más a menudo– a medida que los sistemas regidos por IA se vuelven más y más accesibles: noticias falsas, imitación de voces para perpetrar estafas, imágenes engañosas que pueden alimentar la desinformación (Donald Trump o Susanna Griso siendo detenidos, un concurso de famosos comiendo cemento, el Papa con una indumentaria pintoresca…), la posibilidad de simular como propios trabajos hechos por IA (algo cada vez más frecuente en centros educativos)… los riesgos de una inteligencia sin control se multiplican indiscriminadamente.

«Las sociedades no están todavía preparadas para asumir el impacto de esta tecnología», valora para El Debate Idoia Salazar, experta en la materia y parte del equipo que está elaborando el sandbox (entorno de pruebas controlado) de regulación en IA del Gobierno de España. «Esta IA generativa es muy potente y va a afectar a muchísimos puestos de trabajo, y la sociedad no sabe todavía ni qué es. Hace falta una reestructuración, mucha educación, dejar de lado prejuicios y ver de qué manera puede acompañar la tecnología para hacer crecer de manera positiva a la humanidad».

Salazar es consciente de que estos sistemas pueden ser puestos al servicio de propósitos perversos o malintencionados, pero reitera su potencial para el «aumento de las capacidades humanas». Y confía en el poder de contención de la normativa –europea, en este caso–, aunque no siempre vaya por delante de los vertiginosos avances que se van sucediendo: «Ahora, con la legislación que se está preparando, van a estar cubiertos muchos de los sesgos discriminatorios por los que se puede guiar la IA. ¿Qué esto avanza muy rápido y va a suponer que tengamos que ir actualizándola? Pues sí. Pero no debemos detener el flujo de la tecnología, porque es tremendamente útil y puede ayudar mucho al ser humano. Antes, eso sí, tenemos que prepararle para que sepa utilizarla».